Create MLによって画像分類モデル(Image Classifier)をドラッグ&ドロップでつくれるようになったので、

そのモデル(.mlmodel)をドラッグ&ドロップするだけでリアルタイム画像認識アプリとして試せるOSSをつくりました(2年前に)。

で、最近1、Create MLが物体検出2モデル(Object Detector)の学習もサポートしたので、

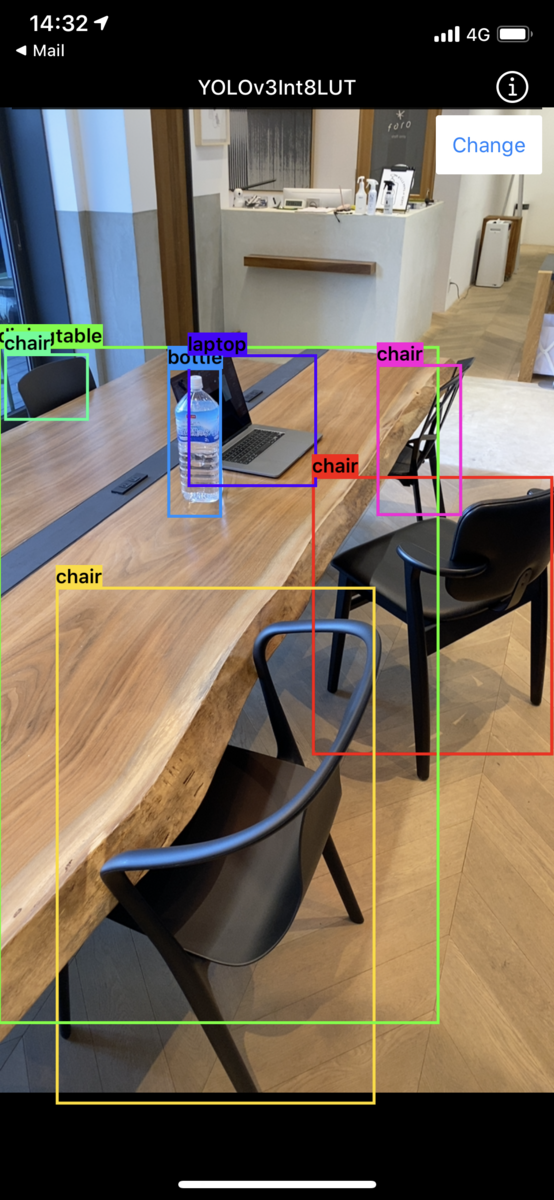

拙作MLModelCameraでも物体検出モデルをサポートしました。

Create MLで学習させた物体検出モデルやAppleが配布しているYOLOv3、coremltools公式リポジトリに変換サンプルのあるSSDといった物体検出モデルをmodelsフォルダ配下に置いてビルドするだけで試せます。

バウンディングボックスの可視化の実装はサイズの換算とか地味に面倒だし既存実装を探すのも面倒、ということでmlmodelを自作する際には非常に便利かと思います。(自分でよく使っています。)